如何理解Transformer论文中的positional encoding,和三角函数有什么 …

如何理解Transformer论文中的positional encoding,和三角函数有什么关系? 最近研究Transformer论文,知道positional encoding是为了引入位置信息,但是不明白为什么这样就可以引入位置信息了,还 …

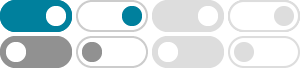

position embedding和position encoding是什么?有什么区别?

position embedding和position encoding是什么? 有什么区别? 最近看了一些NLP的paper,发现大家都在使用position embedding(或者是position encoding)。 但是大部分论文没有详… 显示全部 关注者 …

十分钟读懂旋转编码(RoPE) - 知乎

Sep 23, 2025 · 旋转位置编码(Rotary Position Embedding,RoPE)是论文 Roformer: Enhanced Transformer With Rotray Position Embedding 提出的一种能够将相对位置信息依赖集成到 self …

Position Encoding 是怎么回事? - 知乎

Position Encoding 是怎么回事? 自然语言处理里的 Position Encoding (PE) sentence representation 和BoW一起出现在论文里 显示全部 关注者 98 被浏览

nn.Transformer怎么使用? - 知乎

Positional Encoding:位置编码。 用于为token编码增加位置信息,例如I love you这三个token编码后的向量并不包含其位置信息 (love左边是I,右边是you这个信息),位置信息非常重要。 Linear+Softmax: …

BERT为何使用学习的position embedding而非正弦position encoding?

横坐标为positional encoding的维数i,纵坐标为位置pos 不同位置的position encoding做点乘的可视化。 点乘结果会随着相对位置的增加而递减。 当时学习transfer的时候对positional encoding的认识就到 …

transformer中使用的position embedding为什么是加法? - 知乎

3.2 深度影响分析 Ke et al. (2021) - “Rethinking Positional Encoding” 的发现: 浅层网络(层):拼接可能略有优势 深层网络(12层+):加法表现更稳定,拼接优势消失 超大规模:拼接的内存开销成为 …

Transformer使用position encoding会影响输入embedding的原特征吗?

Transformer使用position encoding会影响输入embedding的原特征吗? Transformer中加入了位置编码,为什么加入它后模型就能够学到位置信息? 它在这里到底是怎么起作用的? 还有加入位置编码 …

基于Decoder的LLM为何需要位置编码? - 知乎

1. 绝对位置编码Absolute Positional Encoding, APE 直接为序列中的每一个绝对位置赋予一个独一无二的编码向量。 a) 三角函数位置编码(原版Transformer) 是原版Transformer论文《Attention Is All …

再论大模型位置编码及其外推性(万字长文) - 知乎

Sep 23, 2025 · 大模型基础组件 - Position Encoding 聊聊大模型位置编码及其外推性 Transformer Architecture: The Positional Encoding TENER: Adapting Transformer Encoder for Named Entity …